Jak poznat, zda je nějaký text strojově generovaný? Dejte ho přepsat jinému jazykovému modelu.

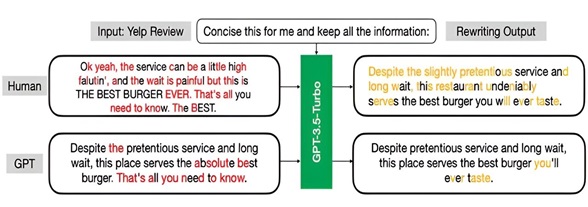

Junfeng Yang a Carl Vondrick přišli s novým systémem Raidar (geneRative AI Detection viA Rewriting), který posuzuje původ textu podle toho, kolik změn v něm udělá jiný jazykový model. Přitom není třeba mít přístup k vnitřnímu fungování žádného systému AI. Text napsaný člověkem má prostě po žádosti o přepsání tendenci vyvolat více modifikací než ten strojově generovaný. Umělá inteligence pokládá výstupy jiné AI už za víceméně optimální…

Raidar míru změn i rovnou vyhodnotí; může jít údajně o texty různých typů, blogy stejně jako recenze produktů. Systém má být také velmi přesný i v případě krátkých textů nebo úryvků. Konkurenční techniky zpravidla k dosažené pořádné přesnosti potřebují texty delší.

Tým plánuje rozšířit své zkoumání na různé oblasti, včetně obsahu ve více jazycích a programovacích kódů (opět ve více jazycích). Zkoumají také detekci strojově generovaných obrázků, videí a zvuků.

Studie včetně použitých datových sad a kódů je prozatím k dispozici na preprintovém serveru arXiv.

Chengzhi Mao et al, Raidar: geneRative AI Detection viA Rewriting, arXiv (2024). DOI: 10.48550/arxiv.2401.12970

Zdroj: Columbia University School of Engineering and Applied Science / TechXplore.com

Poznámky PH:

Otázka zní, zda i řada textů psaných lidmi (odborné, formalizované apod.) pak také nebude modelem LLM schválena celkem bez výhrad. Nakonec čím kultivovanější projev, tím víc možná připomíná strojově generovaný…? Pokud někdo vytvoří strojově dezinformaci, může do jí snadno přidat ručně pravopisnou chybu, nějaký „lidský prvek“ – a nebo se to naučí provádět už samotný LLM.

Za další, jednotlivé modely se v různé míře od sebe liší, například pokročilejší bude spíše přepisovat ten méně pokročilý (nebo svou starší verzi) než naopak? (A když nevíme, který model eventuálně text vytvořil, nemůžeme ani dělat pokusy, zda „přepíše sám sebe“.)

Co se pak týče kódu v programovacích jazycích, ale ten původně napsali lidé a dnešní LLM ho spíš jen najdou a nabídnou – samy neprogramují. (Ale jiné automatizované systémy ano.)

A nakonec – čím dál víc obsahu bude mít asi povahu kombinovanou, možná to celé rozlišování postupně ztratí smysl a lidé bez LLM prostě psát přestanou, podobně jako si při počítání pomáháme kalkulačkou?

Credit: Yang and Vondrick labs

Sciencemag.cz

Sciencemag.cz

napada me, jestli clovek v textu nepouziva casteji nejake slovo nebo konstrukci. ale umela inteligence treba mixuje formulace, takze se tak casto neopakuje.

V podstatě je to všechno v pytli, když se AI začne používat všude (deepfake obrázky a videa, texty, využití i pro specifickou kriminalitu, trollení atd.). Kdo pak rozezná realitu…?

No, v technickych textech se nekdy pozaduje naopak vzdy stejny termin… To, jak bohatou slovni zasobu ma clovek, je pro kazdeho individualni… A navic v anglictine se opakovani tehoz slova cca nepovazuje za vadu, alespon tak me ucili… (Se v teto souvislosti uvadi scena z Hobita, jak k Bilbovi prijdou trpaslici a pak pod sebou „He said…“ asi 10krat. By se v teto souvislosti dalo si hrat s prekladaci, ale i s temi AI – dam jim ten text na prepsani/posouzeni, zda by zkusili obmenovat…)

Myslím že AI neumí dělat myšlenkové pauzy, které jsou úmyslně řečené